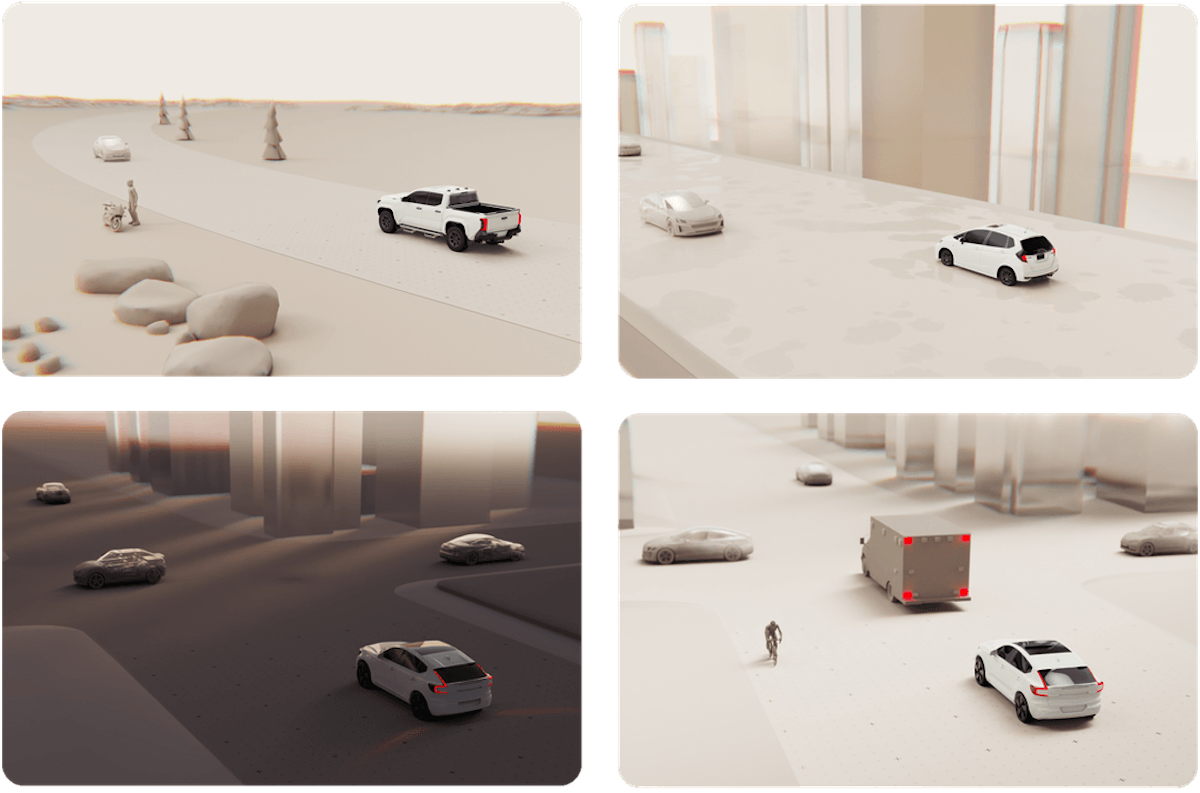

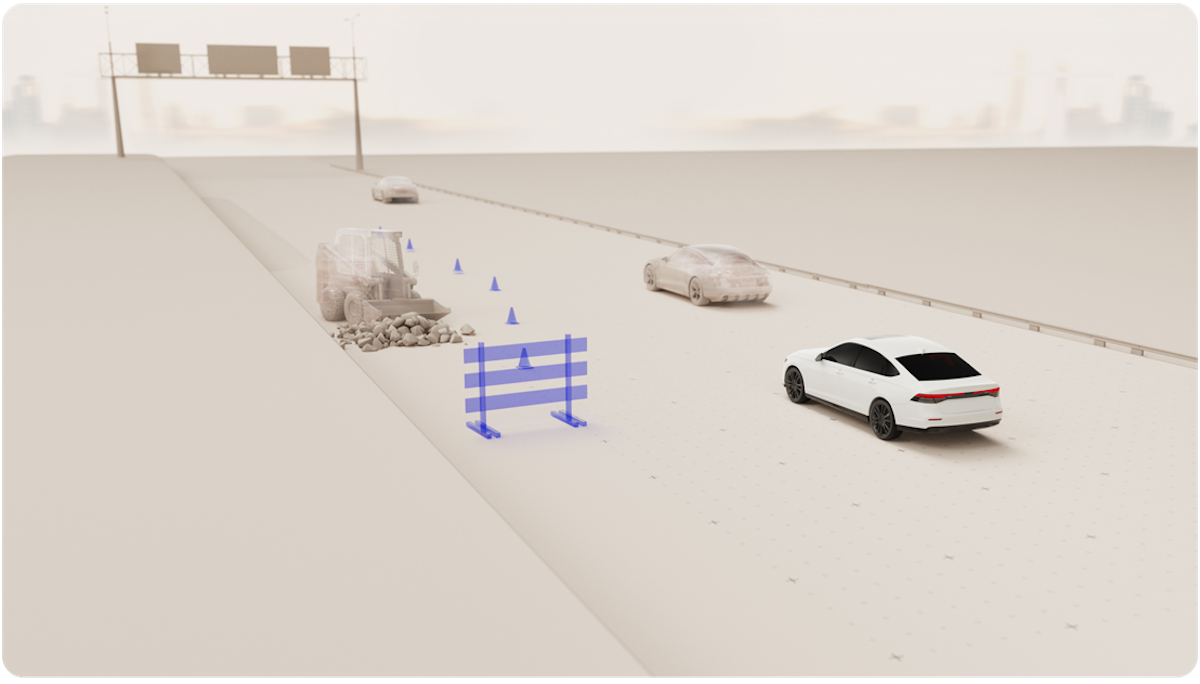

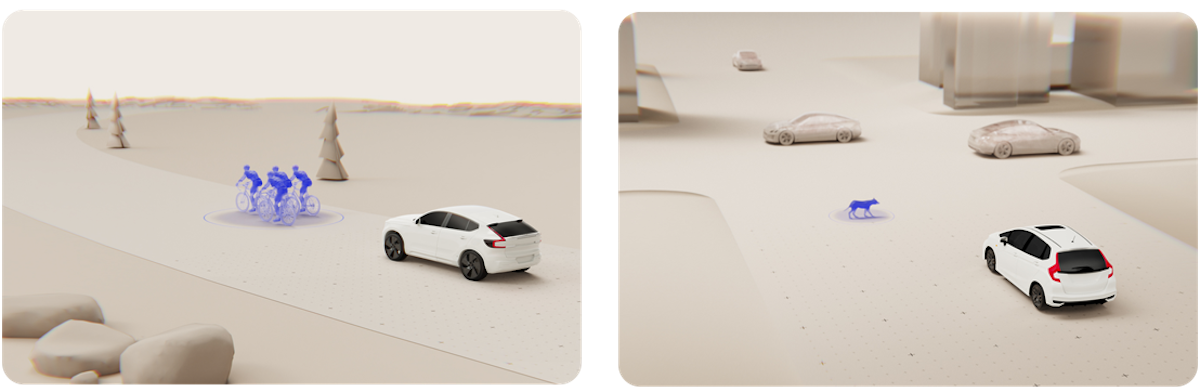

Helm.ai與Honda合作的核心在於「端到端E2E AI架構」,讓AI能直接從原始感測輸入(如影像與雷達資料)中學習駕駛行為,跳過傳統的中間層環境重建過程。這種設計讓AI以更接近人類駕駛的方式理解環境與決策,從「看見」到「行動」形成連貫的決策鏈。進一步結合Helm.ai的Deep Teaching™與生成式AI技術,系統能在無需大量人工標註的情況下自我進化,這在開發效率與可擴充性上,遠超過現有感測融合型自駕架構。

傳統自駕技術開發仰賴龐大的「標註資料庫」,必須由人工或半自動化工具為感測資料加上「正確答案」,才能進行監督式學習。而Helm.ai的非監督式學習技術,則讓AI能自行辨識資料中的特徵與關聯,不需預設答案即可歸納環境特性。這意味Honda在訓練自駕演算法時,無需動員大量測試車與標註人力,開發週期與成本可顯著下降。同時,AI學習的多樣性更高,也能快速適應不同國家與城市的交通習慣與道路條件,對於Honda這樣的全球品牌而言,這是一項極具戰略意義的技術突破。

目前像Tesla、Waymo與Cruise等業者,多半採用兩條主流路線:Tesla以視覺為主的E2E學習架構,仰賴龐大行駛資料進行實際學習;Waymo則以多感測融合與高精地圖為基礎,追求冗餘安全與精確定位。而Honda與Helm.ai的E2E AI策略則介於兩者之間,技術哲學更偏向「減少感測、增加智慧」的方向。Helm.ai的非監督式學習讓AI在較少資料與硬體配置下仍具高效率學習能力,使Honda得以開發成本更低、可快速量產的ADAS與半自駕技術。

與Tesla仰賴數十億公里行駛資料相比,Honda可透過Helm.ai的Deep Teaching™模型,以更少的資料達成相似的決策智慧,同時避免高成本LiDAR與高精地圖依賴。這讓Honda能以更務實的成本結構,推出具備實際市場競爭力的智慧駕駛輔助方案。

Honda計畫在2027年前後,於北美與日本市場推出的新世代電動車與油電車上,搭載基於Helm.ai技術開發的E2E AI駕駛輔助系統。該系統可在市區道路與高速公路運作,實現自動加速、減速、轉向與變換車道等功能,達成高階且自然的輔助駕駛效果。這種以AI學習為核心的ADAS,有望在可靠性、駕駛自然度與開發成本三方面取得平衡,並成為Honda邁向軟體定義車輛(Software Defined Vehicle, SDV)時代的核心技術。

整體而言,Honda與Helm.ai的合作象徵自駕技術從「硬體導向」邁向「智慧導向」的策略轉變。Honda試圖以更輕量化的AI學習系統取代過去高成本、高複雜度的感測器組合,打造能以軟體自我學習與更新的駕駛輔助平台。若Honda能如實在2027本次E2E端到端架構商業化落地,有望重新定義「安全、效率與普及性」的平衡,將成為全球車壇觀察的重要焦點之一。